NVIDIA

BN I&C는 인공지능 컴퓨팅 분야의 세계적인 선도기업 NVIDIA의 Elite Partner로

AI/Deep Learning을 주도하고 있습니다.

NVIDIA DGX Spark

여러분의 책상 위에 있는 Grace Blackwell AI 슈퍼컴퓨터

NVIDIA GB10 Grace Blackwell Superchip으로 구동되는 NVIDIA DGX™ Spark는 전력 효율적인 소형 폼팩터에서 1000 AI TOPS(최고 성능의 AI) 성능을 제공합니다. NVIDIA AI 소프트웨어 스택이 사전 설치되어 있고 128GB 메모리를 탑재하여 개발자는 DeepSeek, Meta, Google 등의 최신 추론 AI 모델을 최대 2,000억 개의 매개변수로 로컬에서 프로토타입을 제작하고, 미세 조정하고, 추론하고, 데이터 센터 또는 클라우드에 원활하게 배포할 수 있습니다.

NVIDIA GPU, CPU, 네트워킹 및 AI 소프트웨어 기술

NVIDIA GB10 슈퍼칩

NVIDIA Grace Blackwell 아키텍처를

바탕으로 최대 1000 AI TOPS의 AI 성능을

FP4 정밀도로 경험해 보세요.

128GB의 일관된 통합 시스템 메모리

대용량 통합 시스템 메모리와 함께

최대 2,000억 개의 매개변수가 있는 AI

모델을 통해 AI 개발 및 테스트

워크로드를 실행해 보세요.

NVIDIA ConnectX 네트워킹

고성능 NVIDIA ConnectX 네트워킹으로

2기와 DGX Spark 시스템을 함께 연결하면

최대 4,050억 개의 매개변수가 있는

AI 모델을 처리할 수 있습니다.

NVIDIA AI Software Stack

도구, 프레임워크, 라이브러리, 사전 학습된

모델을 포함한 전체 스택 솔루션을 사용하여

생성형 AI 워크로드를 처리합니다.

NVIDIA DGX Spark

| 아키텍처 | NVIDIA Grace Blackwell |

|---|---|

| GPU | 블랙웰 아키텍처 |

| CPU | 20코어 Arm, 10 Cortex-X925 + 10 Cortex-A725 Arm |

| CUDA 코어 | 블랙웰 세대 |

| 텐서 코어 | 5세대 |

| 텐서 성능 | 1000 AI TOPS |

| 시스템 메모리 | 128GB LPDDR5x, 통합 시스템 메모리 |

| 메모리 인터페이스 | 256비트 |

| 메모리 대역폭 | 273GB/초 |

| 저장 | 자체 암호화 기능이 있는 1 또는 4TB NVME.M2 |

| USB | 4x USB 4 TypeC (최대 40Gb/s) |

| 이더넷 | 1x RJ-45 커넥터 10GbE |

| NIC | ConnectX-7 스마트 NIC |

|---|---|

| 와이파이 | 와이파이 7 |

| 블루투스 | BT 5.3 w/LE |

| 오디오 출력 | HDMI 멀티채널 오디오 출력 |

| 전력 소비 | 170와트 |

| 디스플레이 커넥터 | 1x HDMI 2.1a |

| NVENC | NVDEC | 1배 | 1배 |

| OS | 엔비디아 DGX™ OS |

| 시스템 사이즈 | 150mm 길이 × 150mm 너비 × 50.5mm 높이 |

| 시스템 무게 | 1.2kg |

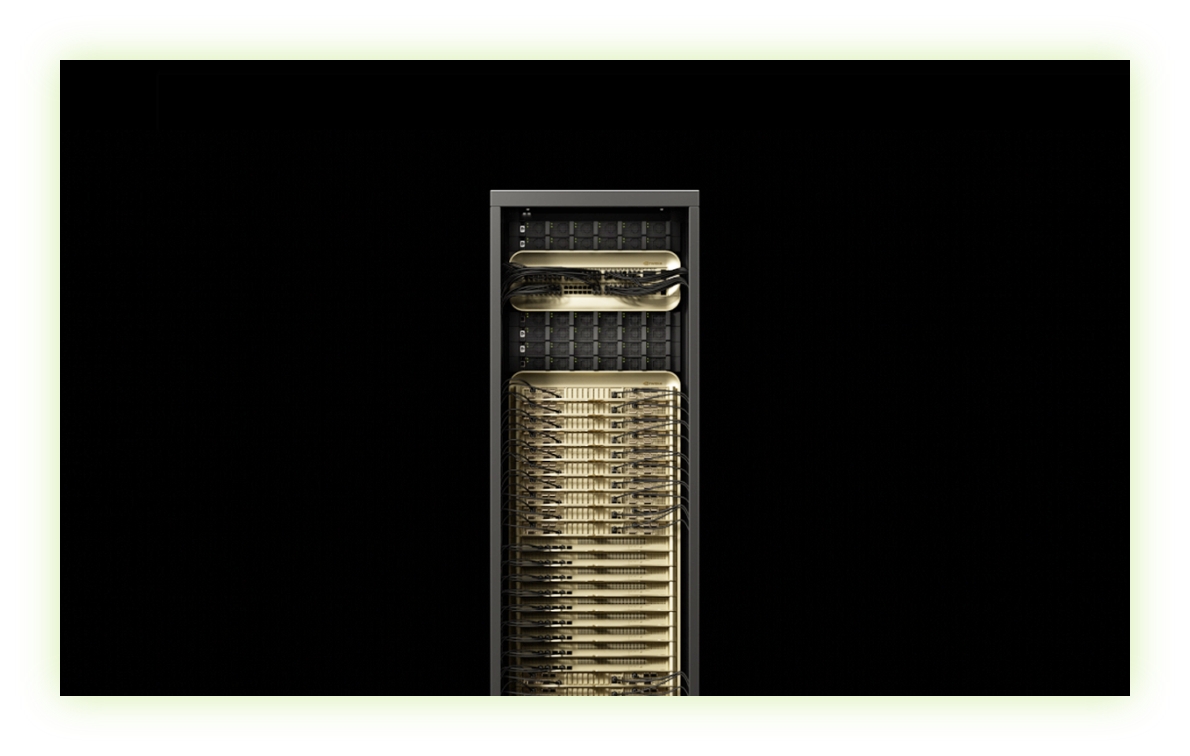

NVIDIA GB300 NVL72

AI 추론시대를 위해 설계된 랙 스케일 아키텍처

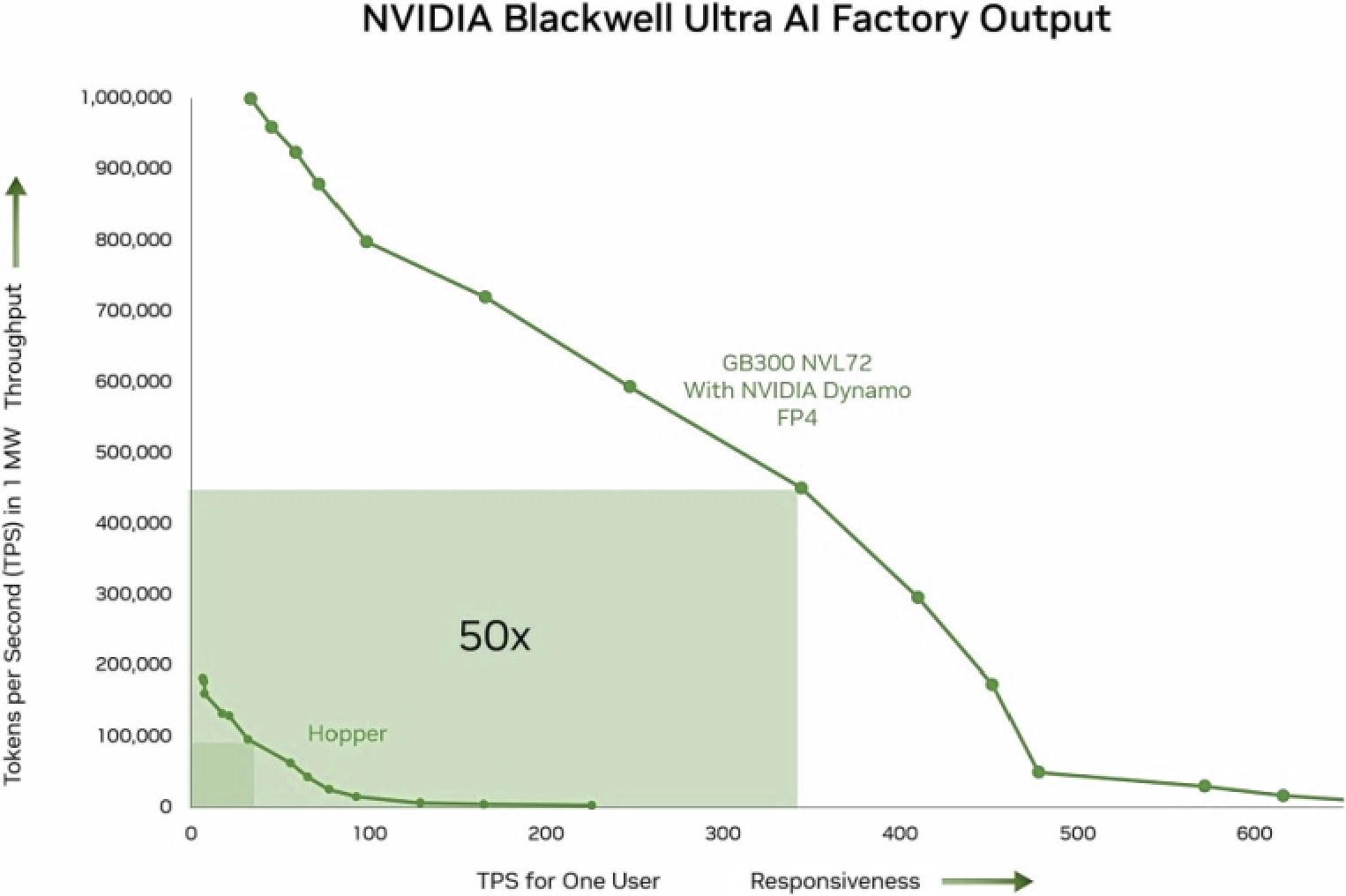

NVIDIA GB300 NVL72는 완전 수냉식 랙 스케일 설계를 특징으로 하며, 72개의 NVIDIA Blackwell Ultra GPU와 36개의 Arm® 기반 NVIDIA Grace™ CPU를 단일 플랫폼에 통합하여 테스트 시간 확장 추론에 최적화되어 있습니다. NVIDIA Quantum-X800 InfiniBand 또는 Spectrum™-X 이더넷과 ConnectX®-8 SuperNIC을 함께 사용하는 GB300 NVL72 기반 AI 팩토리는 NVIDIA Hopper™ 플랫폼 대비 50배 더높은 추론 모델 추론 성능을 제공합니다 .

AI 팩토리를 전례 없는 수준으로 확장

DeepSeek R1 ISL = 32K, OSL = 8K, FP4 Dynamo 분할 기능을 갖춘 GB300 NVL72. FP8 인플라이트 배칭 기능을 갖춘 H100. 예상 성능은 변경될 수 있습니다.

NVIDIA GB300 NVL72 플랫폼으로 차원이 다른 AI 추론 성능을 경험해 보세요. GB300 NVL72는 Hopper 대비 사용자 응답성(사용자당 TPS)이 10배,

처리량(메가와트(MW)당 TPS)이 5배 향상되었습니다. 이러한 발전은 AI 팩토리의 전체 생산량을 50배나 증가시키는 놀라운 성과로 이어집니다.

NVIDIA DGX Spark

AI 추론

테스트 시간 확장 및 AI 추론은 서비스 품질과 최대 처리량 달성에 필요한 컴퓨팅 성능을 향상시킵니다. NVIDIA Blackwell Ultra의 텐서 코어는 NVIDIA Blackwell GPU 대비 이전세대 계층 가속이 2배, AI 컴퓨팅 초당 부동 소수점 연산(FLOPS)이 1.5배 더 강력합니다.

288GB의 HBM3e

더 큰 메모리 용량으로 더 큰 배치 크기와 최대 처리량 성능이 가능합니다. NVIDIA Blackwell Ultra GPU는 추가된 AI 컴퓨팅과 함께 1.5배 더 큰 HBM3e 메모리를 제공하여 가장 긴 컨텍스트 길이에 대한 AI 추론 처리량을 높입니다.

NVIDIA Blackwell 아키텍처

NVIDIA Blackwell 아키텍처는 가속 컴퓨팅 분야에서 획기적인 발전을 이루어, 비교할 수 없는 성능, 효율성, 규모의 새로운 시대를 열었습니다.

NVIDIA ConnectX-8 SuperNIC

NVIDIA ConnectX-8 SuperNIC의 입출력(I/O) 포트들은 두 개의 ConnectX-8 장치를 호스트하여 NVIDIA GB300 NVL72의 각 GPU에 초당 800기가비트(Gb/s)의 네트워크 연결을 제공합니다. 이를 통해 NVIDIA Quantum-X800 InfiniBand 또는 Spectrum-X 이더넷 네트워크 플랫폼과 함께 최고의 원격 직접 메모리 액세스(RDMA) 기능을 제공하여 AI 워크로드의 통합을 극대화할 수 있습니다.

NVIDIA 그레이스 CPU

NVIDIA Grace CPU는 최신 데이터 센터 워크로드를 위해 설계된 혁신적인 프로세서입니다. 탁월한 성능과 메모리 대역폭을 제공하며, 현재 주요 서버 프로세서보다 2배 높은 에너지 효율을 자랑합니다.

5세대 NVIDIA NVLink

가속 컴퓨팅의 잠재력을 최대한 활용하려면 모든 GPU 간의 원활한 통신이 필요합니다. 5세대 NVIDIA NVLink™는 AI 추론 모델의 지속확장 성능을 구현하는 스케일업형 상호 연결 기술입니다.

NVIDIA GB300 NVL72

| 구성 | 72개의 NVIDIA Blackwell Ultra GPU, 36개의 NVIDIA Grace CPU |

|---|---|

| NVLink 대역폭 | 130TB/초 |

| 빠른 메모리 | 최대 40TB |

| GPU 메모리 | 대역폭 | 최대 21TB | 최대 576TB/s |

| CPU 메모리 | 대역폭 | LPDDR5x를 탑재한 최대 18TB SOCAMM | 최대 14.3TB/s |

| CPU 코어 수 | 2,592개의 Arm Neoverse V2 코어 |

| FP4 텐서 코어 | 1,400 | 1,100² PFLOPS |

| FP8/FP6 텐서 코어 | 720PFLOPS |

|---|---|

| INT8 텐서 코어 | 23PFLOPS |

| FP16/BF16 텐서 코어 | 360PFLOPS |

| TF32 텐서 코어 | 180PFLOPS |

| FP32 | 6PFLOPS |

| FP64/FP64 텐서 코어 | 100테라플롭스 |

DGX GB200 NV72

컴퓨팅의 새로운 시대를 열다

GB200 NVL72는 랙 스케일 수냉식 설계로 Grace CPU 36개와 Blackwell GPU 72개를 연결합니다. 72개의 GPU로 구성된 NVLink 도메인은 단일 대용량 GPU처럼 작동하며, 30배 더 빠른 실시간 조 단위 매개변수를 갖는 대용량 언어 모델(LLM) 추론을 제공합니다. GB200 Grace Blackwell Superchip은 NVIDIA GB200 NVL72 의 핵심 구성 요소로, 두 개의 고성능 NVIDIA Blackwell Tensor Core GPU와 NVIDIA Grace™ CPU를 NVIDIA NVLink™-C2C 상호연결을 사용하여 두 개의 Blackwell GPU에 연결합니다.

NVIDIA GPU, CPU, 네트워킹 및 AI 소프트웨어 기술

블랙웰 아키텍처

NVIDIA Blackwell 아키텍처는 가속 컴퓨팅

분야에서 획기적인 발전을 이루어, 탁월한

성능, 효율성, 확장성을 갖춘 새로운 시대의

컴퓨팅을 선도합니다.

엔비디아 그레이스 CPU

NVIDIA Grace CPU는 AI, 클라우드, HPC

애플리케이션을 구동하는 최신 데이터 센터를

위해 설계된 혁신적인 프로세서입니다.

탁월한 성능과 메모리 대역폭을 제공하며,

현재 주요 서버 프로세서보다 2배 높은

에너지 효율을 자랑합니다.

5세대 NVIDIA NVLink

엑사스케일 컴퓨팅과 수조 개의 매개변수를

가진 AI 모델의 잠재력을 최대한 활용하려면

서버 클러스터의 모든 GPU 간에 빠르고

원활한 통신이 필요합니다. 5세대 NVLink는

수조 개 및 수조 개의 매개변수를 가진 AI

모델의 가속화된 성능을 구현하는

스케일업형 상호 연결 기술입니다.

엔비디아 네트워킹

데이터 센터의 네트워크는 AI 발전과 성능

향상에 중요한 역할을 하며, 분산형 AI 모델 학습

및 생성형 AI 성능의 중추 역할을 합니다.

NVIDIA Quantum-X800 InfiniBand ,

NVIDIA Spectrum™-X800 Ethernet,

그리고 NVIDIA® BlueField®-3 DPU는

수십만 개의 Blackwell GPU에 걸쳐 효율적인

확장성을 제공하여 최적의 애플리케이션

성능을 보장합니다.

GB200 NVL72

| GB200 NVL72 | GB200 Grace Blackwell Superchip | |

|---|---|---|

| 컨피규레이션 | 36 Grace CPU : 72 Blackwell GPUs | 1 Grace CPU : 2 Blackwell GPU |

| FP4 코어1 | 1,440 PFLOPS | 40 PFLOPS |

| FP8/FP6 코어1 | 720 PFLOPS | 20 PFLOPS |

| INT8 Tensor 코어1 | 720 POPS | 20 POPS |

| FP16/BF16 Tensor 코어1 | 360 PFLOPS | 10 PFLOPS |

| TF32 Tensor 코어 | 180 PFLOPS | 5 PFLOPS |

| FP32 | 5,760 TFLOPS | 160 TFLOPS |

| FP64 | 2,880 TFLOPS | 80 TFLOPS |

| FP64 Tensor 코어 | 2,880 TFLOPS | 80 TFLOPS |

| GPU 메모리 대역폭 | 최대 13.4TB HBM3e | 576TB/s | 최대 372GB HBM3e | 16TB/s |

| NVLink 메모리 대역폭 | 130TB/s | 3.6TB/s |

| CPU 코어 수 | 2,592 Arm® Neoverse V2 코어 | 72 Arm Neoverse V2 코어 |

| CPU 메모리 대역폭 | 최대 17TB LPDDR5X | 최대 18.4TB/s | 최대 480GB LPDDR5X | 최대 512GB/s |

1. 최소성을 가지고 있습니다.

NVIDIA DGX GB300

추론의 시대를 위한 맞춤형 AI 팩토리 인프라

NVIDIA DGX™ GB300은 기업에서 사용할 수 있는 가장 성능이 뛰어나고 규모가 가장 큰 AI 시스템입니다. NVIDIA Grace™ Blackwell Ultra Superchips 로 제작되고 최대 수천 개까지 확장 가능한 DGX GB300은 NVIDIA MGX™ 랙을 사용하는 최신 데이터 센터에 맞게 설계된 랙 스케일 액체 냉각 시스템입니다. DGX GB300을 사용하면 세계 유수의 기업이 성능 병목 현상을 극복하고 조직에 모든 문제를 해결할 수 있는 인프라 솔루션을 제공할 수 있습니다.

NVIDIA GPU, CPU, 네트워킹 및 AI 소프트웨어 기술

NVIDIA Grace Blackwell Ultra Superchip 기반

Grace Blackwell Ultra Superchip 으로 구동되는

NVIDIA DGX GB300은 학습, 학습 후, 테스트 시간 추론의 성능을

극대화하도록 설계되어 NVIDIA DGX GB200 보다

추론 성능이 1.5배 향상되었습니다.

세계적 수준의 인프라 복원력

NVIDIA Mission Control은 소프트웨어로 제공되는 세계적

수준의 전문 지식을 통해 워크로드에서 인프라까지 AI 운영을

간소화합니다. NVIDIA Blackwell 데이터 센터를 구동하는

Mission Control은 인프라 회복성을 위한 풀스택 인텔리전스를

제공하여 모든 기업이 하이퍼스케일 효율성으로 AI 팩토리를

운영할 수 있도록 합니다.

현대 데이터 센터를 위해 설계됨

DGX GB300 시스템을 탑재한 NVIDIA DGX SuperPOD는

데이터 센터 엔지니어링의 최신 발전을 활용하도록 설계된

간단하고 배포하기 쉬운 랙 아키텍처를 통해 대규모

AI 인프라를 배포할 때 추측 작업을 제거합니다.

NVIDIA GB300 NVL72

| 그래픽 카드 | Grace Blackwell Ultra Superchip에 탑재된 72개의 NVIDIA Blackwell Ultra GPU |

|---|---|

| CPU 코어 | 2592 |

| GPU 메모리 HBM3e | 20.1TB |

| 전체 빠른 메모리 | 37.9TB |

| 성능 | FP4 AI 성능 1400페타플롭스 FP8 AI 성능 700페타플롭스 FP16 AI 성능 350페타플롭스 |

| 네트워킹 | 800Gb/s NVIDIA InfiniBand를 갖춘 72x OSFP 단일 포트 NVIDIA ConnectX®-8 VPI 200Gb/s NVIDIA InfiniBand 및 이더넷을 갖춘 18x 듀얼 포트 NVIDIA BlueField®-3 VPI |

|---|---|

| NVIDIA NVLink 스위치 시스템 | 9x L1 NVIDIA NVLink 스위치 |

| 관리 네트워크 | RJ45를 탑재한 호스트 베이스보드 관리 컨트롤러(BMC) |

| 소프트웨어 | NVIDIA Mission Control NVIDIA AI Enterprise NVIDIA DGX OS / Ubuntu |

| 엔터프라이즈 지원 | 3년간 비즈니스 표준 하드웨어 및 소프트웨어 지원 |

NVIDIA DGX GB200

조 단위 매개변수 AI시대의 선택

NVIDIA DGX™ GB200을 통해 기업은 전례 없는 성능과 예측 가능한 가동 시간을 달성하여 활용도와 생산성을 획기적으로 높이고 AI 이니셔티브의 ROI를 높일 수 있습니다. 이를 통해 AI 성능, 신뢰성 및 확장성에 대한 새로운 표준을 마련할 수 있습니다. 최대 수만 개의 GPU와 NVIDIA DGX SuperPOD를 지원하는 효율적인 수냉식 DGX GB200 랙 규모 설계는 NVIDIA GB200 Grace Blackwell Superchips를 활용하여 오늘날의 고급 생성 AI 애플리케이션에 필요한 최첨단 AI 모델을 해결합니다.

가동 시간이 일정한 엔터프라이즈 생성형 AI 인프라

개발자 생산성 극대화

지능형 제어 평면은 하드웨어, 소프트웨어 및 데이터센터 인프라

전반에서 수천 개의 데이터 포인트를 추적하여 지속적인

운영 및 데이터 무결성을 보장하고 유지 관리를 계획하며 가동

중단 시간을 방지하도록 클러스터를 자동으로 재구성합니다.

거대 생성형 AI를 위한 대규모 슈퍼컴퓨팅

최대 수만 개의 NVIDIA GB200 슈퍼칩으로 확장할 수 있는

DGX GB200 시스템을 갖춘 DGX SuperPOD는 최첨단

1조개 파라미터 생성형 AI 모델에 대한 학습 및 추론을

손쉽게 수행할 수 있습니다.

NVIDIA Grace Blackwell 기반

각각 하나의 Grace CPU와 두 개의 Blackwell GPU가 탑재된

NVIDIA GB200 슈퍼칩은 5세대 NVLink를 통해 연결되어

초당 1.8테라바이트(TB/s)의 GPU-to-GPU

대역폭을 달성합니다.

NVIDIA DGX B300

AI 추론을 위한 AI 팩토리의 기반

NVIDIA DGX™ B300은 생성형 AI의 컴퓨팅 수요를 충족하도록 맞춤 제작된 AI 인프라 솔루션입니다. NVIDIA Blackwell Ultra GPU를 기반으로 하는 DGX B300은 최신 데이터센터에 원활하게 맞도록 설계된 새로운 폼 팩터에서 이전 세대보다 11배 향상된 추론 및 4배 향상된 훈련 성능을 제공합니다. NVIDIA MGX™ 와 기존 엔터프라이즈 랙과 호환되며 풀스택 소프트웨어와 함께 AI 배포를 간소화하고 효율화하여 모든 기업이 하이퍼스케일러처럼 운영할 수 있도록 지원합니다.

추론 시대를 위한 AI 팩토리

LLM 추론을 위한 실시간 파워하우스

Blackwell Ultra GPU를 기반으로 하는 DGX B300은

엔터프라이즈에 대형 언어 모델(LLM) 학습 및 추론을

가속화할 수 있는 단일 플랫폼을 제공합니다. 192페타플롭스의

추론 성능을 제공하여 모든 기업이 하이퍼스케일러처럼

운영할 수 있습니다.

효율적이고 지속 가능한 혁신

여러 전력 옵션 중에서 선택할 수 있는 DGX B300은

가장 에너지 효율적인 AI 슈퍼컴퓨터로 설계되어

탁월한 에너지 효율과 와트당 성능을 제공합니다.

혁신적인 인프라 표준

DGX B300은 최신 데이터센터에 맞게 재설계되었으며 최초로

NVIDIA MGX 랙에 배포 가능해졌습니다. 이 새로운

업계 표준은 데이터센터 엔지니어링의 변화를 가속화하고 있으며

획기적인 성능과 효율을 그 어느 때보다 쉽게 달성

할 수 있도록 지원합니다.

NVIDIA DGX B300

| GPU | NVIDIA Blackwell Ultra GPU |

|---|---|

| CPU | 듀얼 Intel® Xeon® 프로세서 |

| 총 GPU 메모리 | 2.3테라바이트 |

| 성능 | 72 PFLOPS FP8 학습 144 PFLOPS FP4 추론 |

| 네트워킹 | 8개의 OSFP 포트는 8개의 단일 포트 NVIDIA ConnectX-8 VPI를 제공 8개의 OSFP 포트는 8개의 단일 포트 NVIDIA ConnectX-8 VPI를 제공 2x 듀얼 포트 QSFP112 NVIDIA BlueField-3 DPU 최대 800Gb/s NVIDIA InfiniBand/Ethernet |

| 관리 네트워크 | RJ45 1GbE RJ45 호스트 베이스보드 관리 컨트롤러(BMC)가 있는 1GbE 온보드 NIC |

|---|---|

| 저장 | OS: 2x 1.9TB NVMe M.2 내부 저장소: 8x 3.84TB NVMe E1.S |

| 전력 소비 | ~14kW |

| 소프트웨어 | NVIDIA DGX OS / NVIDIA Mission Control / NVIDIA AI Enterprise /NVIDIA Base Command Manager Red Hat Enterprise Linux / Rocky / Ubuntu를 지원 |

| 엔터프라이즈 지원 | 3년간 비즈니스 표준 하드웨어 및 소프트웨어 지원 |

NVIDIA DGX B200

훈련, 미세 조정 및 추론을 위한 통합 AI 플랫폼

NVIDIA DGX™ B200은 AI 여정의 모든 단계에서 규모와 관계없이 기업을 위한 개발에서 배포로 전환하는 파이프라인용 통합 AI 플랫폼입니다. 5세대 NVIDIA® NVLink™로 상호 연결된 8개의 NVIDIA Blackwell GPU를 탑재한 NVIDIA DGX B200은 이전 세대 시스템보다 3배 높은 훈련 성능과 15배 높은 추론 성능을 제공합니다. DGX B200은 NVIDIA Blackwell 아키텍처를 활용하여 거대 언어 모델(LLM), 추천 시스템 및 챗봇 등의 다양한 워크로드를 처리할 수 있어 AI 혁신을 가속화하고자 하는 기업에 이상적입니다.

추론 시대를 위한 AI 팩토리

개발에서 배포로 전환하는 파이프라인용 단일 플랫폼

기업이 훈련부터 fine-tuning, 추론에 이르기까지 AI 파이프

라인의 모든 단계에서 복잡한 AI 데이터세트를 처리하려면

막대한 양의 컴퓨팅 성능이 필요합니다. 기업은 NVIDIA DGX

B200을 통해 워크플로우를 가속화하도록 구축된

단일 플랫폼으로 개발자를 지원할 수 있습니다.

AI 성능의 강자

컴퓨팅 분야의 발전을 위한 NVIDIA Blackwell 아키텍처를

기반으로 한 DGX B200은 DGX H100보다 3배 높은 훈련

성능과 15배 높은 추론 성능을 제공합니다.

NVIDIA DGX BasePOD™ 및 NVIDIA DGX SuperPOD™를

기반으로 DGX B200은 모든 워크로드에 최첨단 성능을 제공합니다.

검증된 인프라 표준

NVIDIA DGX B200은 NVIDIA Base Command 및

NVIDIA AI Enterprise 소프트웨어, 타사에서 지원하는

풍부한 생태계, NVIDIA 전문 서비스의 전문가 자문을

받아볼 수 있는 권한 등 전체 NVIDIA AI 소프트웨어 스택을

포함하는 완전한 하드웨어 및 소프트웨어 플랫폼입니다.

NVIDIA DGX B200

| GPU | 8x NVIDIA Blackwell GPU |

|---|---|

| GPU 메모리 | 총 1,440GB의 GPU 메모리 |

| 성능 | 72페타플롭스 훈련 및 144페타플롭스 추론 |

| 소비 전력 | 최대 14.3kW |

| CPU | Intel® Xeon® Platinum 8570 프로세서 2개 총 112개 코어, 2.1GHz(기본), 4GHz(최대 부스트) |

| 시스템 메모리 | 최대 4TB |

| 네트워킹 | 싱글 포트 NVIDIA ConnectX-7 VPI 8개 제공 OSFP 포트 4개 최대 400Gb/s NVIDIA InfiniBand/이더넷 2x 듀얼 포트 QSFP112 NVIDIA BlueField-3 DPU 최대 400Gb/s NVIDIA InfiniBand/이더넷 |

| 관리 네트워크 | 10Gb/s 온보드 NIC(RJ45 포함) 100Gb/s 듀얼 포트 이더넷 NIC RJ45가 포함된 호스트 베이스보드 관리 컨트롤러(BMC) |

|---|---|

| 스토리지 | OS: 2x 1.9TB NVMe M.2 내부 스토리지: 8x 3.84TB NVMe U.2 |

| 소프트웨어 | NVIDIA AI Enterprise: 최적화된 AI 소프트웨어 NVIDIA Base Command: 오케스트레이션, 스케줄링 및 클러스터 관리 NVIDIA DGX OS / Ubuntu: 운영 체제 |

| 랙 장치(RU) | 10 RU |

| 시스템 크기 | 높이: 444mm(17.5인치) 너비: 482.2mm(19.0인치) 길이: 897.1mm(35.3인치) |

| 작동 온도 | 5~30°C(41~86°F) |

| 엔터프라이즈 지원 | 하드웨어 및 소프트웨어에 대한 3년 엔터프라이즈 비즈니스 표준 지원 연중무휴 엔터프라이즈 지원 포함 엑세스 현지 업무 시간 동안의 실시간 어시스턴트 지원 |

NVIDIA DGX H200

엔터프라이즈 AI 팩토리를 위한 전 세계의 검증된 선택

NVIDIA DGX™ H200으로 비즈니스 혁신과 최적화의 지평을 넓혀보세요. DGX 플랫폼의 일부인 DGX H200은 NVIDIA DGX SuperPOD™ 및 DGX BasePOD™의 기반이 되는 AI 강자로 NVIDIA H200 Tensor코어 GPU의 획기적인 성능으로 가속화 되었습니다.

가장 완벽한 AI 팩토리

AI 우수 센터의 핵심

NVIDIA Base Command™ , NVIDIA AI Enterprise

소프트웨어 제품군, NVIDIA DGXperts의 전문가 조언이

포함된 완벽하게 통합된 하드웨어 및 소프트웨어 솔루션인

NVIDIA DGX H200을 기반으로 AI Center of Excellence를

구축하세요.

AI 확장을 위한 장벽 돌파

NVIDIA DGX H200 아키텍처를 통해 32페타플롭스의

AI 성능과 이전 세대보다 2배 빠른 네트워킹, 그리고 고속 확장성을

경험해 보세요. 이 솔루션은 생성 AI, 자연어 처리, 딥 러닝

추천 모델을 포함한 대규모 워크로드에 최적화되어 있습니다.

귀하에게 맞춤화된 AI 인프라

온프레미스, 코로케이션 , 관리형 서비스 제공업체 임대 등

비즈니스에 맞는 다양한 방식 으로 NVIDIA DGX H200의

강력한 성능을 경험해 보세요. DGX 지원 라이프사이클 관리

(DGX-Ready Lifecycle Management)를 통해 기업은 예측 가능한

재무 모델을 통해 최첨단 구축 환경을 유지할 수 있습니다.

NVIDIA DGX H200

| GPU | 8개의 NVIDIA H200 Tensor Core GPU |

|---|---|

| GPU 메모리 | 총 1,128GB의 GPU 메모리 |

| 성능 | 32petaFLOPS FP8 |

| NVIDIA NVSwitch | 4개 |

| System Power Usage | 최대 ~10.2kW |

| CPU | 듀얼 Intel® Xeon® Platinum 8480C 프로세서 총 112코어, 2.00GHz(기본), 3.80GHz(최대 부스트) |

| 시스템 메모리 | 2TB |

| 네트워킹 | 8개의 단일 포트 NVIDIA ConnectX-7 VPI를 제공하는 4개의 OSFP 포트, 최대 400Gb/s NVIDIA InfiniBand/Ethernet |

|---|---|

| 관리 네트워크 | RJ45를 탑재한 10Gb/s 온보드 NIC, RJ45를 탑재한 100Gb/s 이더넷 옵션 NIC, 호스트 베이스보드 관리 컨트롤러(BMC) |

| 저장 | OS: 2×1.9TB NVMe M.2 내부 저장소: 8×3.84TB NVMe U.2 |

| 소프트웨어 | NVIDIA AI Enterprise – 최적화된 AI 소프트웨어 NVIDIA Base Command – 오케스트레이션, 스케줄링 및 클러스터 관리 NVIDIA DGX OS / Ubuntu / Red Hat Enterprise Linux / Rocky – 운영 체제 |

| 시스템 무게 | 287.6lb (130.45kgs) |

| 시스템 크기 | 높이: 14.0인치(356mm) 너비: 19.0인치(482.2mm) 길이: 35.3인치(897.1mm) |

| 작동 온도 | 5~30°C (41~86°F) |

NVIDIA DGX SuperPOD

고유한 AI 수요를 위한 맞춤형 시스템

NVIDIA DGX SuperPOD™는 가장 까다로운 AI 학습 및 추론 워크로드를 위한 민첩하고 확장 가능한 성능을 갖춘 선도적인 AI 인프라를 제공합니다. NVIDIA DGX™ 플랫폼 에서 NVIDIA Blackwell 기반 컴퓨팅 옵션을 선택할 수 있는 DGX SuperPOD는 단순한 하드웨어의 집합이 아니라, 업계 최고의 컴퓨팅, 스토리지, 네트워킹, 소프트웨어 및 인프라 관리 기능을 모두 포함하는 풀스택 데이터센터 플랫폼으로, 서로 연동하여 대규모 환경에서 최대 성능을 제공하도록 최적화되어 있습니다.

세계 최초의 턴키 AI 데이터 센터

테스트 및 검증된 솔루션,

DGX SuperPOD

DGX SuperPOD는 엔터프라이즈의 성능 및

안정성 요구 사항을 충족하는 예측 가능한

솔루션입니다. NVIDIA에서 DGX SuperPOD를

광범위하게 테스트하며 엔터프라이즈 AI

워크로드로 최대한도까지 밀어붙이기 때문에

애플리케이션 성능을 걱정할 필요가 없습니다.

항상 개선되는 고급 인프라

소프트웨어

DGX SuperPOD는 NVIDIA Base

Command™를 기반으로 합니다.

NVIDIA Base Command는 AI 워크플로

관리, 컴퓨팅, 스토리지 및 네트워크 인프라를

가속하는 라이브러리, AI 워크로드에 최적화된

운영 체제 등을 포함하는 검증된

소프트웨어입니다.

NVIDIA Base Command

Manager를 통한 간소화된 관리

NVIDIA Base Command Manager를

통해 DGX SuperPOD의 배포, 소프트웨어

프로비저닝, 지속적인 모니터링 및 상태

확인을 원활하게 자동화할 수 있습니다.

전담 전문 지식 및 서비스

DGX SuperPOD에는 설치에서 인프라 관리,

워크로드 확장, 생산 AI 간소화에 이르는 전담

전문 서비스가 포함됩니다. 세계 최대 AI 전문

실무자 팀과 직접 연결 할 수 있는 경로인

DGXpert에 대한 전용 액세스를

이용할 수 있습니다.

AI혁신의 중심 글로벌 포털사, N사

초거대 생성형 AI 학습용 NVIDIA DGX SuperPOD 구축

DGX SuperPOD는 N**ER CLOVA가 한국 및 일본 시장을 위한 최첨단 언어 모델을 구축 하고

글로벌 시장에서 강력한 AI 플랫폼 플레이어로 발전할 수 있도록 지원하고 있습니다.

디지털 혁신을 주도하는 통신사, K사

한국형 언어모델 개발용 NVIDIA DGX SuperPOD 구축

NVIDIA DGX SuperPOD의 강력한 성능과 NeMo의 최적화된 알고리즘 및 3D 병렬 처리 기술로

LLM을 더 효과적으로 훈련했습니다. 다른 플랫폼을 사용하는 것도 고려해 보았지만 하드웨어 수준에서

추론 수준까지 아우르는 전체 스택 환경을 제공하는 대안을 찾기가 어려웠습니다.

NVIDIA DGX BasePod

엔터프라이즈 AI 팩토리를 위한 인프라 토대

필수 인프라를 통해 AI 엔터프라이즈로 혁신

AI는 헬스케어에서 제조, 금융 서비스에 이르는 모든 산업 분야의 주요 업무용 사용 사례를 지원합니다. NVIDIA DGX™ 플랫폼의 일부로서 NVIDIA DGX BasePOD™는 기업이 AI 인프라를 구축하고 확장할 수 있는 레퍼런스 아키텍처를 제공합니다.

NVIDIA DGX BasePOD로 주요 업무용 AI 사용 사례 지원

건강 및 생명 과학

이미지 주석을 가속화하고, 게놈

시퀀싱 워크플로우를 가속화하고,

연구 혁신을 촉진하는 AI

애플리케이션을 만드세요.

금융 서비스

대화형 AI, 알고리즘 트레이딩,

사기 감지 등 임무 수행에 중요한

AI 사용 사례를 배포합니다.

에너지

시뮬레이션을 통해 우물 계획을

최적화하고, AI 기반 컴퓨터

비전으로 운영을 개선하고,

재생 에너지 생산을 예측합니다.

통신

AI를 활용하여 고객 경험을 개선하고,

복잡한 네트워크 운영을 최적화하고,

데이터에서 비즈니스 통찰력을 추출하여

운영을 최적화하세요.

대규모 언어 모델 (LLM)

일상적인 작업의 자동화부터 창의적인

콘텐츠 생성까지, 귀하의

산업에 맞는 생성적 AI 모델을

빠르게 훈련하고 맞춤화하세요.

AI혁신의 중심 글로벌 포털사, N사

초거대 생성형 AI 학습용 NVIDIA DGX SuperPOD 구축

DGX SuperPOD는 N**ER CLOVA가 한국 및 일본 시장을 위한 최첨단 언어 모델을 구축 하고

글로벌 시장에서 강력한 AI 플랫폼 플레이어로 발전할 수 있도록 지원하고 있습니다.

디지털 혁신을 주도하는 통신사, K사

한국형 언어모델 개발용 NVIDIA DGX SuperPOD 구축

NVIDIA DGX SuperPOD의 강력한 성능과 NeMo의 최적화된 알고리즘 및 3D 병렬 처리 기술로

LLM을 더 효과적으로 훈련했습니다. 다른 플랫폼을 사용하는 것도 고려해 보았지만 하드웨어 수준에서

추론 수준까지 아우르는 전체 스택 환경을 제공하는 대안을 찾기가 어려웠습니다.